Ο ανιχνευτής ψεύδους AI νικά τους ανθρώπους και θα μπορούσε να είναι κοινωνικά ανατρεπτικός

Ερευνητές από το Πανεπιστήμιο του Würzburg και το Ινστιτούτο Max-Planck για την Ανθρώπινη Ανάπτυξη εκπαίδευσαν ένα μοντέλο τεχνητής νοημοσύνης να ανιχνεύει τα ψέματα και αυτό θα μπορούσε να διαταράξει τον τρόπο με τον οποίο επικοινωνούμε μεταξύ μας.

Οι άνθρωποι δεν είναι πολύ καλοί στο να καταλαβαίνουν αν κάποιος λέει ψέματα ή αν λέει την αλήθεια. Πειράματα δείχνουν ότι το ποσοστό επιτυχίας μας είναι περίπου 50% στην καλύτερη περίπτωση και αυτή η κακή επίδοση υπαγορεύει τον τρόπο με τον οποίο εμπλεκόμαστε μεταξύ μας.

Η θεωρία της προεπιλεγμένης αλήθειας (TDT) λέει ότι οι άνθρωποι συνήθως υποθέτουν ότι αυτό που τους λέει ένα άτομο είναι αλήθεια. Το κοινωνικό κόστος του να αποκαλέσουμε το άτομο ψεύτη είναι πολύ μεγάλο ρίσκο με την ικανότητά μας να ανιχνεύουμε ψέματα με ποσοστό 50/50 και ο έλεγχος των γεγονότων δεν είναι πάντα πρακτικός τη στιγμή.

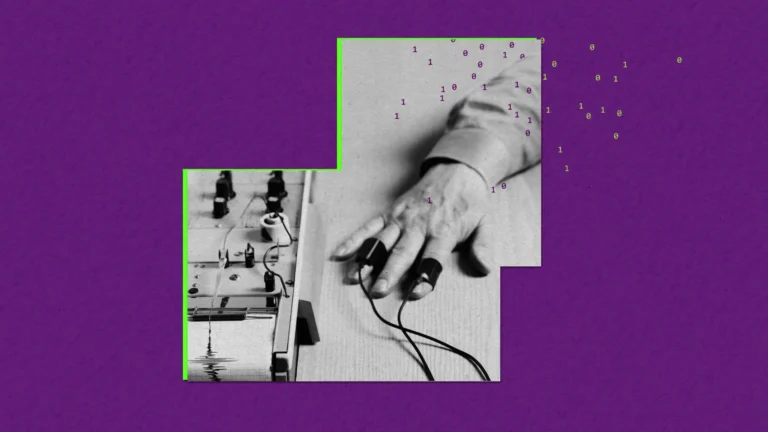

Οι τεχνολογίες ανίχνευσης ψεύδους μπορούν να εντοπίσουν δεδομένα όπως δείκτες άγχους και κινήσεις των ματιών αλλά με περιορισμένη ακρίβεια. Θα μπορούσε να βοηθήσει η τεχνητή νοημοσύνη;

Το έγγραφο εξηγεί πώς η ερευνητική ομάδα εκπαίδευσε το BERT LLM της Google να ανιχνεύει πότε οι άνθρωποι λένε ψέματα.

Οι ερευνητές στρατολόγησαν 986 συμμετέχοντες και τους ζήτησαν να περιγράψουν τα σχέδια του Σαββατοκύριακου με μια επεξήγηση που θα υποστήριζε την αλήθεια της δήλωσής τους.

Στη συνέχεια τους παρουσιάστηκαν τα σχέδια του Σαββατοκύριακου ενός άλλου συμμετέχοντα και τους ζητήθηκε να γράψουν μια ψευδή υποστηρικτική δήλωση υποστηρίζοντας ότι αυτά ήταν στην πραγματικότητα τα δικά τους σχέδια για το Σαββατοκύριακο.

Το BERT εκπαιδεύτηκε στο 80% των 1.536 δηλώσεων και στη συνέχεια του ανατέθηκε να αξιολογήσει την ειλικρίνεια του υπολοίπου των δηλώσεων.

Το μοντέλο μπόρεσε να χαρακτηρίσει με ακρίβεια μια δήλωση ως αληθή ή ψευδή με ακρίβεια 66,86%, σημαντικά καλύτερη από τους ανθρώπινους κριτές, οι οποίοι πέτυχαν ποσοστό ακρίβειας 46,47% σε περαιτέρω πειράματα.

Θα χρησιμοποιούσατε έναν ανιχνευτή ψεύδους τεχνητής νοημοσύνης;

Επιλογή Χρήσης Ανιχνευτή Ψεύδους AI: Όταν δόθηκε στους συμμετέχοντες η επιλογή να χρησιμοποιήσουν έναν ανιχνευτή ψεύδους AI, μόνο το ένα τρίτο από αυτούς επέλεξε να το κάνει. Αυτό δείχνει ότι η πλειοψηφία των ανθρώπων ίσως να μην είναι άνετη με την ιδέα να βασιστούν σε ένα τέτοιο σύστημα ή μπορεί να μην το θεωρούν αξιόπιστο.

Ακολουθία Αλγοριθμικών Προβλέψεων: Από αυτούς που επέλεξαν να χρησιμοποιήσουν τον ανιχνευτή ψεύδους AI, σχεδόν όλοι ακολούθησαν τις αλγοριθμικές προβλέψεις. Αυτό σημαίνει ότι οι χρήστες είχαν μεγάλη εμπιστοσύνη στις εκτιμήσεις του αλγορίθμου και βασίστηκαν σε αυτές είτε για να αποδεχτούν μια δήλωση ως αληθινή είτε για να την απορρίψουν ως ψευδή.

Ποσοστά Κατηγορίας: Οι συμμετέχοντες που αναζήτησαν τις αλγοριθμικές προβλέψεις έδειξαν ποσοστό κατηγορίας (δηλαδή, ποσοστό να κατηγορήσουν κάποιον ότι λέει ψέματα) σχεδόν 85% όταν ο ανιχνευτής AI υπέδειξε ότι η δήλωση ήταν ψευδής. Αυτό είναι πολύ υψηλότερο από το βασικό ποσοστό των συμμετεχόντων που δεν ζήτησαν τις αλγοριθμικές προβλέψεις, το οποίο ήταν περίπου 19,71%. Αυτό δείχνει ότι οι αλγοριθμικές προβλέψεις έχουν σημαντική επίδραση στην κρίση των ανθρώπων.

Μεταφορά Ευθύνης: Οι ερευνητές προτείνουν ότι μια πιθανή εξήγηση για την τάση αυτή είναι ότι η παρουσία ενός ανιχνευτή ψεύδους AI επιτρέπει στους ανθρώπους να μεταφέρουν την ευθύνη για τις κατηγορίες ψεύδους από τους ίδιους στο σύστημα. Δηλαδή, αντί να πουν “Σε αποκαλώ εγώ ψεύτη”, μπορούν να πουν “Η μηχανή σε αποκαλεί ψεύτη”. Αυτό μειώνει την αίσθηση της προσωπικής ευθύνης για την κατηγορία.

Συνοψίζοντας, η μελέτη δείχνει ότι οι άνθρωποι που επιλέγουν να χρησιμοποιήσουν έναν ανιχνευτή ψεύδους AI τείνουν να εμπιστεύονται τις εκτιμήσεις του σε μεγάλο βαθμό και είναι πιο πρόθυμοι να κατηγορήσουν κάποιον για ψέμα όταν υποστηρίζεται από την τεχνολογία. Επιπλέον, η ύπαρξη της τεχνολογίας παρέχει μια ψυχολογική διέξοδο, επιτρέποντας στους χρήστες να μεταφέρουν την ευθύνη των κατηγοριών στην τεχνητή νοημοσύνη.

Τι θα συνέβαινε στις κοινωνίες μας αν οι άνθρωποι είχαν 4 φορές περισσότερες πιθανότητες να αρχίσουν να αποκαλούν ο ένας τον άλλον ψεύτη;

Οι ερευνητές κατέληξαν στο συμπέρασμα ότι αν οι άνθρωποι βασίζονταν στην τεχνητή νοημοσύνη ως κριτή της αλήθειας, αυτό θα μπορούσε να έχει ισχυρές ανατρεπτικές δυνατότητες.

Το έγγραφο σημειώνει ότι “τα υψηλά ποσοστά κατηγοριών μπορεί να επιβαρύνουν τον κοινωνικό μας ιστό, καλλιεργώντας τη γενικευμένη δυσπιστία και αυξάνοντας περαιτέρω την πόλωση μεταξύ ομάδων που ήδη δυσκολεύονται να εμπιστευτούν η μία την άλλη”.

Ένας ακριβής ανιχνευτής ψεύδους τεχνητής νοημοσύνης θα είχε επίσης θετικές επιπτώσεις. Θα μπορούσε να εντοπίσει την παραπληροφόρηση και τις ψευδείς ειδήσεις που δημιουργούνται από την ΤΝ, να βοηθήσει στις επιχειρηματικές διαπραγματεύσεις ή να καταπολεμήσει την ασφαλιστική απάτη.

Τι γίνεται με την ηθική της χρήσης ενός τέτοιου εργαλείου;

Αξιοπιστία και Ακρίβεια:

– Ψευδώς Θετικά/Αρνητικά: Οι αλγόριθμοι δεν είναι τέλειοι και μπορούν να παράγουν ψευδώς θετικά (κατηγορίες για ψέμα όταν η δήλωση είναι αληθινή) και ψευδώς αρνητικά (αποδοχή ψέματος ως αλήθεια). Αυτό μπορεί να έχει σοβαρές συνέπειες, ειδικά σε νομικά ή επαγγελματικά πλαίσια.

– Μεροληψία: Οι αλγόριθμοι μπορεί να περιέχουν μεροληψία με βάση τα δεδομένα εκπαίδευσής τους, οδηγώντας σε άδικες κατηγορίες εναντίον συγκεκριμένων ομάδων ανθρώπων.

Μεταφορά Ευθύνης:

– Ηθική Ευθύνη: Όπως αναφέραμε, η χρήση του ανιχνευτή ψεύδους AI επιτρέπει στους ανθρώπους να μεταφέρουν την ευθύνη για τις κατηγορίες από τον εαυτό τους στο σύστημα. Αυτό μπορεί να μειώσει την προσωπική ευθύνη και να οδηγήσει σε αδίκες κατηγορίες χωρίς επαρκή ανάλυση των γεγονότων.

Ιδιωτικότητα και Συναίνεση:

– Συναίνεση: Οι άνθρωποι που υπόκεινται σε ανίχνευση ψεύδους AI πρέπει να έχουν δώσει τη συναίνεσή τους, γνωρίζοντας πλήρως πώς λειτουργεί το σύστημα και τις συνέπειες της χρήσης του.

– Ιδιωτικότητα: Η συλλογή και ανάλυση δεδομένων από τις εκφράσεις του προσώπου, τον τόνο της φωνής ή άλλα βιομετρικά στοιχεία μπορεί να παραβιάζει την ιδιωτικότητα των ατόμων.

Ψυχολογικές Επιπτώσεις:

– Ψυχολογική Πίεση: Η χρήση ενός ανιχνευτή ψεύδους μπορεί να δημιουργήσει ψυχολογική πίεση στους ανθρώπους, ακόμα και αν λένε την αλήθεια, λόγω του φόβου ότι μπορεί να κατηγορηθούν λανθασμένα.

– Απώλεια Εμπιστοσύνης: Η υπερβολική εξάρτηση από την τεχνολογία μπορεί να μειώσει την εμπιστοσύνη στις διαπροσωπικές σχέσεις και στην ανθρώπινη κρίση.

Νομικά και Κανονιστικά Ζητήματα:

– Κανονισμοί: Πρέπει να υπάρξουν κανονισμοί και πρότυπα για τη χρήση ανιχνευτών ψεύδους AI ώστε να διασφαλιστεί η δικαιοσύνη και η διαφάνεια στη χρήση τους.

– Νομική Ευθύνη: Σε περίπτωση λάθους, είναι σημαντικό να καθοριστεί ποιος φέρει τη νομική ευθύνη – ο προγραμματιστής του αλγορίθμου, ο χρήστης ή κάποιος άλλος.

Εν κατακλείδι, η χρήση ανιχνευτών ψεύδους τεχνητής νοημοσύνης έχει πολλές ηθικές και πρακτικές προκλήσεις που πρέπει να εξεταστούν προσεκτικά πριν υιοθετηθεί σε ευρεία κλίμακα. Είναι απαραίτητο να διασφαλιστεί ότι η τεχνολογία χρησιμοποιείται με τρόπο που προάγει την δικαιοσύνη, προστατεύει την ιδιωτικότητα και την αξιοπιστία και λαμβάνει υπόψη τις ανθρώπινες ηθικές αξίες.

Πηγή: kinitanea.gr

Γεννημένος στην Αθήνα, στις αρχές της δεκαετίας του ’90, έχοντας ήδη πατήσει τα 30, ο υποφαινόμενος, με σπουδές στην Ψυχολογία, παραμένει ανήσυχος, ανικανοποίητος, λάτρης της συνεχούς αναζήτησης, μανιώδης συλλέκτης αντικειμένων που σχετίζονται με τις προσφιλείς του δραστηριότητες.